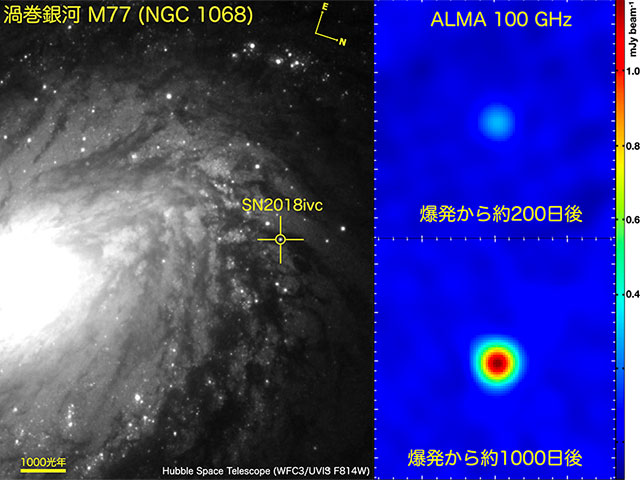

人工知能の「ブラックボックス」を開く

人工知能はますます強力になり、人々の日常生活に浸透していますが、これらのシステム内で何が起こっているのかわからないことがよくあります。それらの非透明性は、実際的な問題、さらには人種差別を助長する可能性があります。そのため、研究者はこの「ブラックボックス」を開いてAIを説明可能にしたいと考えています。

2013年2月、エリックルーミスは、米国ウィスコンシン州の小さな町ラクロスを車で走り回っていました。そのとき、彼は警察に止められました。彼が運転していた車が銃撃に巻き込まれたことが判明し、彼は逮捕されました。最終的に、裁判所は彼に懲役6年の刑を言い渡した。

裁判官が決定を下すのを助けた技術がなかったら、これは問題のない事件だったかもしれません。彼らは、被告が再犯者になるリスクを決定するアルゴリズムであるCOMPASを使用しました。裁判所は、被告の人口統計情報などのさまざまなデータをシステムに入力します。これにより、被告が再び犯罪を犯す可能性のスコアが得られます。

ただし、アルゴリズムがこれをどのように予測するかは、不透明なままです。言い換えれば、このシステムはブラックボックスであり、Loomisが2017年に米国最高裁判所で苦情を申し立てた慣行です。彼は、COMPASが性別と人種のデータを使用して決定を下し、アフリカ系アメリカ人を再犯のリスクが高いとランク付けしたと主張しました。裁判所は最終的に彼の訴訟を却下し、アルゴリズムがなくても判決は同じだったと主張した。しかし、COMPASが再犯を正確に予測していないことを示唆する多くの啓示もありました。

可決

アルゴリズムによる量刑システムは米国ではすでに使用されていますが、ヨーロッパでは一般的に採用が制限されています。 AオランダのAIの量刑制度は、企業への支払い遅延などのプライベートな例で判断することを、例えば、重要なメディアの報道の後に2018年に閉鎖されました。それでも、AIはヨーロッパ中の他の分野に参入しています。これは、ヨーロッパの医師がCovid-19を診断するのを支援するために展開されています。また、AIを使用して住宅ローンの申し込みを分析するBritish M:QUBEのような新興企業が急速に出現しています。

これらのシステムは、アルゴリズムを介して履歴データを実行し、アルゴリズムが予測または一連のアクションを実行します。しかし、そのようなシステムがどのように結論に達するのかわからないことがよくあります。正しく動作するか、内部に技術的なエラーがある可能性があります。デザイナーが気付かないうちに、人種差別のような何らかの形の偏見を再現することさえあるかもしれません。

これが、研究者がこのブラックボックスを開き、AIシステムを透明、つまり「説明可能」なものにしたい理由です。これは、現在勢いを増している動きです。人工知能のEU白書が説明できるAIを呼びかけ、今年初めには、のような大手企業リリースグーグルとIBMはそれの研究に資金を提供しているとGDPRも消費者のためのexplainabilityへの権利が含まれます。

イタリアのピサにある全米研究評議会の情報科学技術研究所の主任研究員であるフォスカ・ジャノッティは、次のように述べています。「しかし、多くの場合、これらのモデルはエンドユーザーにとって理解できないため、説明可能なAIが非常に人気になっています。」

診断

Giannottiは、XAIと呼ばれる説明可能なAIに関する研究プロジェクトを主導しています。このプロジェクトでは、AIシステムに内部ロジックを明らかにさせたいと考えています。このプロジェクトは、医師が診断を下すのに役立つテクノロジーや、誰かにローンを提供するかどうかを銀行に推奨するアルゴリズムなどの自動意思決定支援システムに取り組んでいます。彼らは、AIを説明可能にするのに役立つ技術的な方法や新しいアルゴリズムを開発することを望んでいます。

「人間はまだこれらのシステムで最終決定を下します」とGiannottiは言いました。「しかし、これらのシステムを使用するすべての人間は、提案の背後にある論理を明確に理解している必要があります。’

今日、病院や医師は、意思決定をサポートするためにAIシステムを実験することが増えていますが、意思決定がどのように行われたかを知らないことがよくあります。この場合のAIは、大量の医療データを分析し、患者が特定の病気にかかっている可能性のパーセンテージを生成します。

たとえば、システムは、皮膚がんの症状を表す場合がある人間の皮膚の大量の写真でトレーニングされる場合があります。そのデータに基づいて、皮膚の異常の新しい写真から誰かが皮膚がんにかかる可能性があるかどうかを予測します。これらのシステムはまだ一般診療ではありませんが、病院はますますそれらをテストし、日常業務に統合しています。

これらのシステムは、ディープラーニングと呼ばれる一般的なAI手法を使用することが多く、これには大量の小さな副次的決定が必要です。これらは、数十から数百の深さの層を持つネットワークにグループ化されているため、たとえば、システムが誰かに皮膚がんがあることを示唆した理由を理解したり、誤った理由を特定したりすることは特に困難です。

「ネットワークを設計したコンピューター科学者でさえ、論理を本当に理解できないことがあります」とGiannotti氏は述べています。

自然言語

スペインのサンティアゴデコンポステーラ大学のコンピューターサイエンスと人工知能の教授であるSenénBarroにとって、AIはその決定を正当化できるだけでなく、人間の言語を使用してそれを行うことができるはずです。

「説明可能なAIは、結果を人間に自然に伝えることができるはずですが、結果を正当化する推論プロセスも伝える必要があります」とBarro教授は述べています。

「説明可能なAIは、結果を人間に自然に伝えることができる必要がありますが、結果を正当化する推論プロセスも伝える必要があります。」

説明可能なAIは、結果を人間に自然に伝えることができる必要がありますが、

スペインサンティアゴデコンポステーラ大学セネンバロ教授

結果を正当化する推論プロセスも伝える必要があります。

彼はNL4XAIと呼ばれるプロジェクトの科学コーディネーターであり、説明可能性を実現するための特定の手法など、さまざまなサブ領域を調査することにより、AIシステムを説明可能にする方法について研究者をトレーニングしています。

最終結果はチャットボットに似ている可能性があると彼は言います。「自然言語技術は、これらのインタラクティブな説明を人間に伝える会話エージェントを構築することができます」と彼は言いました。

説明を与える別の方法は、システムが反事実を提供することです。「それは、システムがソリューションを変更するために誰かが変更する必要があるものの例を提供することを意味するかもしれません」とGiannottiは言いました。ローン判断アルゴリズムの場合、反事実は、ローンが拒否された人に、承認される最も近いケースを示す場合があります。誰かの給料が低すぎると言うかもしれませんが、彼らが年間ベースでさらに€1,000を稼いだ場合、彼らは資格があります。

白い箱

ジャノッティは、説明可能性には2つの主要なアプローチがあると言います。1つは、結果自体を説明できないブラックボックスアルゴリズムから始めて、内部ロジックを明らかにする方法を見つけることです。研究者は、このブラックボックスシステムに別のアルゴリズム(「説明者」)を添付できます。このアルゴリズムは、ブラックボックスにさまざまな質問をし、その結果を提供された入力と比較します。このプロセスから、説明者はブラックボックスシステムがどのように機能するかを再構築できます。

「しかし、別の方法は、ブラックボックスを破棄し、ホワイトボックスアルゴリズムを使用することです」とGiannotti氏は述べています。これらは、設計によって説明できる機械学習システムですが、多くの場合、対応するブラックボックスよりも強力ではありません。

「どちらのアプローチが優れているかはまだわかりません」とGiannottiは警告しました。「選択は、作業中のデータによって異なります。」高解像度の画像で満たされたデータベースのように、非常に大量のデータを分析する場合、ブラックボックスシステムはより強力であるために必要になることがよくあります。ただし、タスクが軽い場合は、ホワイトボックスアルゴリズムの方が適している可能性があります。

しかし、説明可能性を達成するための正しいアプローチを見つけることは、依然として大きな問題です。研究者は、説明が実際にブラックボックスシステムをうまく説明しているかどうかを確認するための技術的手段を見つける必要があります。「最大の課題は、生成された説明の良さと有効性を検証するための新しい評価プロトコルを定義することです」と、NL4XAIのバロ教授は述べています。

その上、説明可能性の正確な定義はやや不明確であり、それが適用される状況によって異なります。アルゴリズムを作成するAI研究者は、システムを使用して医療診断を行う医師とは異なる種類の説明が必要になります。

NL4XAIの副コーディネーターでサンティアゴデコンポステーラ大学の研究者でもあるホセマリアアロンソ博士は、次のように述べています。 。

それでも、説明可能なAIの推進力は段階的に進んでおり、人間と機械の間の協力が改善されるでしょう。「人間はAIに取って代わられることはありません」とGiannotti氏は述べています。’それらはコンピューターによって増幅されます。しかし、説明はこの協力の重要な前提条件です。